|

|

Популярные авторы:: Борхес Хорхе Луис :: Грин Александр :: БСЭ :: Раззаков Федор :: Толстой Лев Николаевич :: Горький Максим :: Азимов Айзек :: Чехов Антон Павлович :: Компьютерра :: Лондон Джек Популярные книги:: Дюна (Книги 1-3) :: Скандальная леди :: Рагнарёк :: The Boarding House :: Аквариумист :: Алиби актрисы :: Александр Демьяненко :: Храм Диониса :: Бегущая по волнам :: Ифтах и его дочь |

Компьютерра (№255) - Журнал «Компьютерра» № 38 от 17 октября 2006 годаModernLib.Net / Компьютеры / Компьютерра / Журнал «Компьютерра» № 38 от 17 октября 2006 года - Чтение (стр. 3)

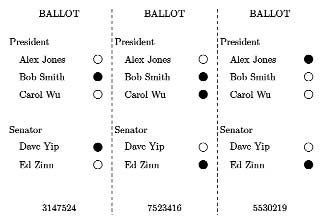

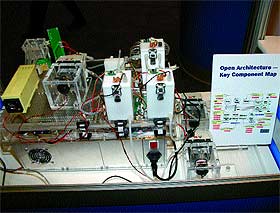

*** В октябре объемы продаж Windows XP Starter Edition пересекли отметку в миллион копий. «Обрезанная» ОС выпущена на 25 языках и в настоящее время используется в 139 странах мира. ТБ *** GameStop и EB Games начали прием предварительных заказов на PlayStation 3. Все приставки, которые эти две американские торговые сети получат от Sony, были зарезервированы в течение одного часа. По разным оценкам, спекулянты на eBay будут продавать PS3 по цене от 1200 до 2500 долларов. ТБ *** Sony прекратила поставки ЖК-мониторов в Японию и США. Европейский рынок компания покинет в декабре. Причины этого шага — слишком высокая конкуренция и низкая прибыль. В то же время Sony продолжит производить дисплеи для профессиональных применений. ТБ *** Sony Pictures выпустила первый фильм на двухслойных дисках Blu-ray емкостью 50 Гбайт — «Click» поступил в продажу в середине октября. К концу года картины на двухслойных Blu-ray появятся также у 20th Century Fox, Lionsgate и Warner Bros. ТБ *** На крупнейшей в мире Франкфуртской книжной ярмарке Google объявила об открытии совместного проекта с ЮНЕСКО (Организация ООН по вопросам образования, науки и культуры). Технически The Literacy Project ничего нового собой не представляет — на главной страничке www.google.com/literacy всего лишь собраны уже существующие сервисы Google, только вот использовать их предлагается для решения конкретной задачи — борьбы с неграмотностью. По данным ЮНЕСКО, сегодня в мире больше миллиарда неграмотных людей старше пятнадцати лет. Google просит организации, работающие в этой сфере, предоставить видеоуроки и другие материалы. Первые несколько сотен подобных фильмов будут индийского производства. Известно, что Болливуд уже давно снимает фильмы, помогающие обучать людей чтению. Помимо «филиала» Google Video, на страничке прописались такие сервисы, как поиск книг и научных статей, географические карты мира (учебным заведениям предлагается указать свое местонахождение), поиск по блогам и Google Groups, с помощью которого можно создать список рассылки или ветвь обсуждения какой-то проблемы. АХ *** Седьмая версия самого распространенного в мире браузера выйдет уже в октябре, сообщает официальный блог разработчиков Microsoft (blogs.msdn.com/ie). Предыдущая версия Internet Explorer была выпущена пять лет назад, в августе 2001 года. За это время многое в мире изменилось, и более свежие версии браузеров Firefox и Opera предлагают пользователям множество новых функций. Internet Explorer 7 будет распространяться через службу Windows Update в качестве важного обновления, что гарантирует быстрое вытеснение старых версий. Напомним, что в семерке появятся такие давно ожидаемые изменения, как поддержка вкладок, RSS, оптимизированный интерфейс, лучшее соответствие веб-стандартам и дополнительные средства для обеспечения безопасного серфинга. СК ***  Американские астрономы сообщили о надежной идентификации внесолнечной планеты, находящейся на рекордно близком расстоянии от Земли. Она обращается вокруг молодой (возраст — 800 млн. лет) звезды, удаленной от нас всего лишь на десять с половиной световых лет (по забавному совпадению в километрах получается круглое число, 100 триллионов) и в ясную погоду видна без всякой оптики. Впервые информация о наличии спутника у Эпсилона Эридана была обнародована еще в 2000 году, но многие специалисты сочли ее недостаточно надежной. Теперь группа астрономов во главе с учеными из Техасского университета провела на орбитальном телескопе имени Хаббла новый трехлетний цикл наблюдений и окончательно установила наличие планеты, масса которой в полтора раза превышает массу Юпитера. Этот газовый гигант обращается вокруг своего светила за 6,85 земного года и в конце 2007-го приблизится к нему на минимальное расстояние. Оптическая яркость планеты в это время увеличится настолько, что появится надежда запечатлеть ее с помощью фотокамеры «Хаббла». Так что не исключено, что через год с небольшим впервые за всю историю астрономии экзопланету удастся увидеть на заранее запланированных снимках. АЛ Верить власти или науке? Автор: Киви Берд Как-то так получается, что естественный процесс привлечения компьютерных систем к организации выборов в органы власти сопровождается неуклонным сокращением контроля общества за правильностью подсчета голосов. Хотя электронные системы голосования можно легко оснастить средствами проверки и помощи в ручном пересчете — на случай возникновения сомнений в правильности работы техники и персонала, — организаторы выборов прибегают к самым разным ухищрениям, дабы подобных средств не существовало. И в США, и в России, и во множестве других стран публику который год пытаются заверить, что чисто электронные системы голосования без «бумажного следа» — это вершина избирательных технологий, замечательная, надежная, всесторонне проверенная специалистами и не нуждающаяся в ручном пересчете голосов. Самое занятное, что именно специалисты по компьютерной безопасности, профессионально занимающиеся проблемами защиты информации, наиболее последовательно и громко выступают против чисто электронных систем голосования, поскольку с их помощью очень просто манипулировать данными. В США, например, где выборы автоматизированы почти во всех штатах, целый ряд авторитетных криптографов и компьютерщиков выступает за возврат к бумажным избирательным бюллетеням — так как ничего более эффективного с точки зрения контроля человечество не придумало. Ярчайшей иллюстрацией этой необычной, надо признать, позиции стала только что опубликованная работа знаменитого криптографа Рональда Райвеста, посвященная новой системе голосования на основе необычного бумажного бюллетеня [theory.csail.mit.edu/~rivest/Rivest-TheThreeBallotVotingSystem.pdf]. Кто такой Райвест, в компьютерном мире пояснять обычно не надо, но если кому-то вдруг невдомек, это «буква R» в самом популярном алгоритме с открытым ключом RSA, автор хеш-функции MD5, шифров RC4 и RC5, не говоря уже о других криптографических протоколах и технологиях, широко применяемых по всей планете. Выдающимся отличием новой системы, придуманной ныне Райвестом для организации честных выборов, является то, что в ней вообще нет никакой криптографии или замысловатой математики.  Упоминание математической криптографии, конечно, не случайно, поскольку за последние десятилетия было разработано немало интересных протоколов для безопасных и проверяемых голосований, но все они опираются на криптографические операции, подразумевают те или иные формы управления ключами, сложноваты в эксплуатации, короче говоря — распространения не получили. В системе голосования по Райвесту используется только бумажный бюллетень. Правда, не традиционный, а состоящий из трех практически одинаковых частей, разделенных перфорацией для легкого отрывания. Каждую часть отличает от соседних (и всех остальных в прочих бюллетенях) уникальный случайно выбираемый номер-идентификатор, напечатанный по нижнему краю. Главная хитрость нового бюллетеня в том, как он заполняется. Если «за», то в строке соответствующего кандидата ставится «птичка» в любых двух из трех частей, чтобы третья осталась незаполненной. А если голосуют «против» кандидата, то «птичка» проставляется в любой из колонок, чтобы две остальные остались пустыми. В качестве квитанции избиратель получает копию любой из трех частей по своему выбору, бюллетень же разделяется на три части, и все они опускаются в избирательную урну. Благодаря такой форме бюллетеня и выдаваемой избирателю «квитанции», удается с высокой степенью достоверности удовлетворить противоречивые требования к демократическим выборам — анонимность голосующих и проверяемость верности учета голосов. Каждый голосующий может лично удостовериться, что его/ее голос зарегистрирован именно за тех, кому был отдан, и что он включен в итоговый протокол. При этом квитанция с единственной «птичкой» не раскрывает, кем и за кого был отдан голос, то есть не может быть использована в скупке голосов избирателей. Журнальная площадь не позволяет рассказать обо всех нюансах, изложенных в пятнадцатистраничной работе ученого. Важно, что суть новой системы достаточно проста, поскольку после сканирования бюллетеней, изъятых из урн, полные результаты подсчетов открыто публикуются на веб-сайте. Именно тут передовые инфотехнологии очень полезны, поскольку в сводных таблицах сайта каждый избиратель может по своей квитанции убедиться в правильности учета своего волеизъявления. Предложенная система, конечно, не идеальна, у нее есть недостатки, охотно признаваемые автором. Но хотя Райвест призывает все заинтересованные стороны к обсуждению и усовершенствованию его модели, крайне маловероятно, что на приглашение откликнутся, скажем, власти США. Или, к примеру, России, где Центризбирком явно движется по проторенной американцами дороге и тоже пытается внедрять безбумажные технологии голосования. Если кто не в курсе, то от продвигавшихся ранее ЦИКом устройств-сканеров КОИБ решено отказаться в пользу устройств КЭГ, построенных на основе сенсорного экрана и не имеющих бумажных распечаток для ручного пересчета. Именно такие безбумажные сенсорные КЭГи в экспериментальном порядке только что использовались на пяти участках в Великом Новгороде в ходе октябрьских выборов в местные органы власти. Как и в аналогичных американских аппаратах, использующий такую машину избиратель просто получает на экране бодрый сигнал, что отданный им голос учтен, а проверить это нет никакой возможности. Ни у избирателя, ни у наблюдателей, следящих за обеспечением честных выборов. Власть заверяет, что это нормально. Но есть ли у народа основания верить власти, если наука свидетельствует об обратном? Intel приблизил сказку к реальности: Intel Developer Forum Fall 2006, Сан-Франциско. Чаcть вторая Автор: Сергей Озеров (Продолжение. Начало см. в #657.) Несмотря на чрезвычайно яркую и эффектную R&D-секцию Форума, все же его основное предназначение — служить огромным техническим брифингом для специалистов. На московском и новосибирском IDF это ощущается слабо, — порой наши соотечественники, сидящие в зале, знают предмет лучше, чем докладчики, читающие чужие, не ими подготовленные презентации. Но на Developer Forum в Сан-Франциско, где выступают сами разработчики новых технологий, дела обстоят иначе. Это одно из тех немногочисленных мероприятий, где начинаешь жалеть, что не можешь находиться в двух-трех местах одновременно: в скромные три дня здесь втискивается под сотню разных докладов-сессий, которые идут с утра до вечера в десятке залов. Причем каждый доклад интересный и глубоко профессиональный. Американцам проще — у них, как правило, очень узкая специализация, а потому они могут выбрать одну из тем Форума и посетить только те сессии, которые ей посвящены (расписание подобрано так, чтобы это было удобно делать). Впрочем, все подготовленные материалы и презентации по ходу Форума выкладываются в онлайн, так что с содержанием пропущенных сессий можно ознакомиться без проблем [Интересующихся отсылаю к www.intel.com/pressroom/kits/events/idffall_2006. Обратите внимание на небольшую ссылку Content Catalog в одной из врезок справа — по ней можно найти все презентации с сессий Форума]. Да и общая организация мероприятия вызывает разве что немое восхищение — все продумано, вплоть до мелочей. За участие в этом великолепии, естественно, просят довольно существенных денег (как-никак, за знания на Западе принято платить), но оно того стоит. Основные идеи и серверы Рассказывали о многом. Самые общие, неспециализированные материалы выносятся в отдельное «шоу достижений», состоящее из нескольких тематических кейноутов (keynotes), представляемых руководителями соответствующих подразделений Intel. Открывающий Форум CEO Intel Пол Отеллини, например, отчитался о достижениях корпорации за минувшие полгода, подробно остановившись на таких «вкусных» вещах, как завоевавшая корону лучшего в мире процессора архитектура Intel Core, невероятное еще не так давно сотрудничество с Apple, полностью перешедшей на соответствующие процессоры; поведал об успехах в применении 65-нм технологического процесса и перспективах быстрого внедрения 45 нм, о прорыве в «потребительских» качествах новых серверных Intel Xeon, о кремниевом лазере и терабитном процессоре, о новой мобильной платформе и многом другом. Что и говорить — корпорации, безусловно, есть чем похвастать. Позднее на отдельном брифинге для прессы СЕО Intel рассказал о некоторых деталях новой модели исследований, пообещав в ближайшие годы придерживаться «чередующейся» схемы, в которой каждый первый год будет выпускаться «улучшенная версия» уже существующей архитектуры (вроде перехода от Pentium M к Core Duo), а каждый второй — «выкатываться» принципиально новая (Core Duo «Yonah» — Core 2 Duo «Conroe»), причем две подобные архитектуры — Nehalem и Gesher уже находятся в разработке (кроме имен о них пока ничего не известно). А вот директор отдела технологий Intel Джастин Раттнер затронул куда более серьезные вещи — серверы и связанные с ними технологии в свете объявленного Intel курса на энергоэффективность. Так, совместно с Луисом Баррозо из Google он подробно рассказал о перспективах изменения существующей инфраструктуры крупных серверных центров. Предполагается перейти от отдельных серверов, использующих широкоупотребительные стандарты электропитания, к современной централизованной распределительной системе, использующей в качестве основного рабочего напряжения не переменный ток на 480 В и 208 В, а постоянный на 360 В, с новыми блоками питания, выдающими не полный комплект напряжений ATX (+3,3, +5, +12, —5, —12 В), а лишь +12 В, которые преобразуют к нужному уровню электронные схемы питания, расположенные на материнской плате и других потребителях. Исключение из схемы практически всех промежуточных преобразований тока (которое возникает в ИБП и трансформаторах) и сильное конструктивное упрощение БП позволяет более чем на треть снизить потери, связанные с передачей и преобразованием энергии и достигающие сейчас 65%. А это дает лишние 60% серверов при той же потребляемой мощности, которой крупному серверному центру требуется столько, что на протяжении его жизни счет за потребленную электроэнергию становится сопоставим со стоимостью оборудования, установленного в центре [В качестве иллюстрации на Форуме был продемонстрирован работающий сервер, потреблявший 3,8 кВт от обычной сети переменного тока и лишь 3,3 кВт — от постоянного. Выигрыш в 14% в дата-центре сегодня вполне ощутим]. Другая новинка — использование в свитчах и оконечном сетевом оборудовании интегрированных схем безопасности, шифрующих в прозрачном режиме весь передаваемый между оборудованием MAC-уровня трафик. В отличие от традиционных «программных» шифрующих решений, работающих на более высоких уровнях, вроде SSL или IPsec, в технологии LinkSec не требуется поддержка шифрования со стороны программного обеспечения или сложной для пользователя процедуры получения и хранения ключей, — шифрование настраивается на уровне сети ее администратором, которому нет дела до передаваемого трафика. Ключи прописываются прямо в сетевое оборудование, с соответствующими гарантиями, что извлечь их оттуда или скопировать будет невозможно. При этом шифрованный трафик свободно уживается с обычным, а сетевое оборудование полностью отвечает стандартам Ethernet — просто в рамках одной большой физической сети возможно создание нескольких виртуальных защищенных. Виртуализация и безопасность Безопасности во всех ее ипостасях на IDF было уделено очень много внимания. На подходе уже первые системы с ее аппаратной поддержкой, и в ближайшие несколько лет разработка «безопасных приложений» и «безопасных операционных систем», несомненно, будет одной из актуальнейших «программистских» тем. Шифрование на канальном уровне — лишь один из аспектов общей проблемы, коротко описывающейся так: главная угроза корпоративным сетям исходит не «извне», а «изнутри» — хакеры предпочитают «внедриться» в сеть, «стать одним из своих», вместо того чтобы преодолевать навороченные файрволлы и IDS на ее границах. И та же LinkSec, востребованная, если хакер попытается физически подключить к сети «чужой» компьютер или иное «прослушивающее» оборудование, будет абсолютно бесполезна, если в одну из машин «доверительной» сети окажется внедрен троянец.  Что делать? Виртуализироваться! Виртуализация, позволяющая создавать на одном компьютере изолированные друг от друга виртуальные машины, и безопасность идут рука об руку, поскольку вместо комплекса мер по защите компьютера в целом — файрволла, антивируса, разграничения прав доступа — достаточно реализовать защиту только сравнительно маленькой программки — менеджера виртуальных машин (VMM). Во-первых, с его помощью можно выстраивать «доверительную пирамиду»: VMM при создании очередного раздела на компьютере проверит «цифровую подпись» загрузчика операционной системы, загрузчик проверит подписи всех исполняемых файлов и данных операционной системы, операционная система будет проверять подписи у всех запускаемых программ, программы — у всех запускаемых скриптов и используемых данных и т. д., где каждый уровень, который мы уже считаем надежным, проверяет надежность следующего уровня. Если аппаратно обеспечить гарантию подлинности самого первого уровня, с которого начинается «пирамида», — а именно это и делают TPM, LaGrande и иже с ними, то на подобном компьютере будет принципиально невозможно запустить что-либо неподписанное кем-то, кому мы доверяем, — в частности, того же троянца. Во-вторых, виртуализация гарантирует, что если «вредная» программа все-таки будет запущена (например, где-то в описанной схеме встретится незащищенный слой, систему безопасности для собственного удобства отключит сам пользователь или, что еще неприятнее, из-за ошибки в софте «подписанная» программа сделает что-нибудь «неприличное» [Как вы помните, «борьба за безопасность» началась еще с введения бита NX/XD, который позволял предотвратить один из самых распространенных видов подобных атак, заставляющих недостаточно аккуратно написанное приложение выполнить произвольный «чужой» код, послав на его вход специально подобранную последовательность данных]), то «погибнет» лишь один из «отсеков корабля», а не вся система. Скажем, дыра в WinAMP или многострадальном Internet Explorer, использующихся в неслужебных целях, не станет причиной компрометации бизнес-приложения, работающего с важными данными, поскольку пробившийся в одну виртуальную машину низкой защиты хакер попросту не увидит недоступные для него остальные машины, на которых запущены более критичные вещи.  Что же нам предлагают? По правде говоря, для меня стало откровением, что несмотря на отсутствие поддерживающего ее программного обеспечения, первая на рынке технология виртуализации VT-x, которую процессоры Intel поддерживают уже около года, за это время несколько раз оптимизировалась по быстродействию, так что производительность использующих ее программ на Core 2 Duo будет заметно выше, чем на первых Pentium D (даже с учетом разницы в производительности самих этих процессоров). Впрочем, сегодня ведущие производители виртуальных машин уже поддерживают VT-x, хотя и не реализуют всех ее потенциальных возможностей, что, впрочем, неудивительно, если учесть, что необходимый для полного раскрытия технологии объем работ сопоставим по сложности с созданием новой операционной системы, да и ОС в идеале должны бы пройти соответствующую оптимизацию. Камень преткновения в данном вопросе — это необходимость реализации работающих на уровне виртуальной машины драйверов для железа и их поддержки операционной системой. Дело в том, что все нынешние ОСи попросту не умеют совместно с другими ОСями одновременно использовать одно и то же оборудование — скажем, общую видеокарту, и приходится либо реализовывать средствами виртуальной машины виртуальный же графический адаптер, жертвуя производительностью и функциональностью, либо ставить, грубо говоря, две видеокарты — по одной на каждую из ОСей, что тоже едва ли можно назвать удачным выходом. Кроме того, если мы собираемся использовать VMM не только для одновременного запуска Linux и пары копий Windows на одной машине, а для более «прогрессивных» схем, в которых, например, предлагается каждому критичному приложению выделять по собственной копии операционной системы, то без поддержки со стороны ОС и запустить это приложение — проблема (потребуется ждать создания новой виртуальной машины и загрузки в ней ОСи, после чего вручную запускать нужную программу), и работать с ним (было бы лучше, если б запущенная на другой виртуальной машине программа выглядела как обычное приложение, а все технические тонкости были спрятаны), и ресурсов на это уйдет слишком много (о быстродействии во многих случаях можно забыть). Словом, объем работы огромен, он наверняка займет еще несколько лет. Так что первые ее по-настоящему интересные плоды мы, вероятно, увидим тогда же, когда и второе поколение виртуализации от Intel, известное сейчас под кодовым названием VT-d.  Для разработчиков VT-d — большой шаг вперед. Например, в этой технологии появится аппаратная поддержка двойной трансляции виртуальной памяти, что позволит обойтись в виртуальных машинах без реализации ее функциональности чисто программным путем, довольно медленным и требующим большого непроизводительного расхода оперативной памяти. Появится возможность предоставления быстрого, без участия VMM доступа к выбранным MSR-регистрам процессора [Эта фича уже реализована в VT-x процессоров архитектуры Intel Core]; появится возможность не сбрасывать при каждом переключении между виртуальными машинами таблицу трансляции виртуальной памяти TLB, — все это тоже должно сильно увеличить быстродействие VT-d по сравнению с VT-x. Появится защита DMA-операций, улучшится поддержка прерываний — что, в свою очередь, повысит безопасность, закрыв некоторые потенциальные дыры. Кстати, интересно, что почти все из вышеперечисленного предлагает в своей технологии Pacifica компания AMD, незадолго до Форума начавшая поставки соответствующих процессоров. Так что Intel, безоговорочно лидировавшая в этой области, рискует на полгода-год — до выхода процессоров и чипсетов с поддержкой VT-d — остаться в хвосте. Впрочем, решение AMD не совместимо с решением Intel, и решатся ли разработчики на «оптимизацию» своего ПО «под AMD» — пока непонятно. Любопытный доклад был посвящен созданию виртуальной машины «от Intel». В свое время, когда еще только появлялись первые процессоры VT-x, я спрашивал на московском Форуме представителей Intel о перспективах создания компанией собственного ПО, дабы потребители могли воспользоваться этой технологией (как известно, Intel разрабатывает и продает довольно много программных продуктов для собственного железа, начиная с компиляторов и заканчивая средствами отладки), но тогда мне сказали, что создание VMM ляжет на плечи сторонних разработчиков (в числе которых, кстати, фигурирует Microsoft), а Intel в лучшем случае поддержит OpenSource-проекты, но уж никак не станет создавать собственный стандарт. Однако ситуация, похоже, меняется, и вместо разговоров о довольно невнятном опенсорсном проекте Xen, на котором демонстрировалась работа VT-x, но который, на мой взгляд, страшно далек был не только от «народа», но и от подавляющего большинства сисадминов [Хотя Novell, включившая Xen в свои версии Linux, пожалуй, со мной не согласится], на Форуме разговор шел уже о более чем понятном и весьма многообещающем Open Virtual Iron, реализующем полноценную, удобную и довольно «навороченную» виртуализацию. Сама Virtual Iron — стартап, предлагающий коммерческое ПО, и подобный поворот в сторону «открытости», да еще и подробно освещенный Intel, выглядит как попытка установить некую собственную «стандартную платформу» в виртуализации.  Что касается более отдаленных перспектив, то Intel уже давно обещает появление поддержки виртуализации на уровне самих устройств, что снимет многие проблемы с их использованием в виртуализированных системах. Но в отличие от VT-d, здесь все зависит не только от Intel, поскольку соответствующие усовершенствования придется вносить во все многообразие современного компьютерного оборудования (помнится, года два назад речь шла даже о специальных клавиатурах, мониторах и мышах!), что потребует перестройки на новый лад огромного количества разработчиков. Оглянитесь вокруг в поисках тотального перехода на давным-давно вышедший PCI Express, который прославляли как безусловный стандарт самого ближайшего будущего, — и вы увидите, что подавляющее большинство разработчиков как использовали старый добрый PCI и более быстрый PCI-X, так и продолжают использовать. Тем не менее комитет PCI-SIG продолжает работу над выработкой спецификаций на устройства, в которых виртуализация будет поддерживаться аппаратно, и наверняка включит их в очередную версию стандарта PCI. Четырехъядерные процессоры и HPC После двухъядерных процессоров, о которых столько говорили в прошлом году, четырехъядерники этого года уже не являются чем-то сильно новым с технологической и маркетинговой точек зрения. Так что вместо отдельных сессий для специалистов они удостоились лишь упоминаний в паре докладов, в которых в очередной раз было подтверждено, что «четыре ядра» от Intel будут объединением двух обычных двухъядерных процессоров в общем корпусе, примерно таким, каким было второе поколение Pentium D, набиравшееся из пары одноядерных кристаллов CedarMill. С одной стороны, это очень выгодно для Intel, поскольку с ее хорошо отлаженной технологией производства подобных «гибридов» она может представить эти «камни» в самые кратчайшие сроки и по минимальной себестоимости. С другой — разделение на «пары» ядер хорошо далеко не для всех приложений, и по некоторым сообщениям, даже оптимизированное параллельное ПО к Kenthsfield’у отнесется равнодушно, в отличие от по-настоящему прорывных в этом отношении Yonah и Conroe. Кроме того, два ядра — это удвоение тепловыделения и нагрузки на схемы питания процессорного сокета, что отрицательно скажется и на только-только завоеванном звании «самых холодных процессоров», и на совместимости с материнскими платами. Главный конкурент — AMD — сейчас активно «играет» на обоих моментах, заявляя, что у нее этих проблем, благодаря использованию «монолитного» четырехъядерного чипа и переходу на 65-нм технологический процесс, не будет. Правда, не стоит забывать, что у нее все это будет после, а у Intel пусть даже «неидеальный», но работающий четырехъядерник — уже сейчас, и не исключен даже такой вариант, что первые четырехъядерные «камни» от AMD выйдут к тому моменту, когда Intel подготовит 45-нм технологический процесс и выпустит на его основе находящиеся сейчас в разработке собственные «монолитные» квады, с перспективой их объединения по той же схеме «двух кристаллов в одном корпусе» в октеты.  Еще один довольно острый вопрос — будут ли востребованы все эти многоядерные процессоры, в том плане, что большое количество ПО до сих пор не оптимизировано даже под двухъядерные CPU. Исключением, пожалуй, можно считать серверы, которые во все времена были многопроцессорными, а потому — рассчитанными на использование распараллеленного ПО: для них переход на новые «камни» обещает пройти гладко. Правда, очень большую роль тут играет обслуживающая процессор инфраструктура, которая нередко стоит куда дороже собственно процессора, а с этим делом у Intel в последнее время дела обстояли не очень хорошо, что выразилось в ослаблении позиций в традиционно консервативном серверном сегменте и тоже дало лишний козырь AMD, последние несколько лет ориентирующейся как раз на развитие собственной инфраструктуры, «платформы» с максимально продолжительным сроком жизни и вдобавок открытой для всех желающих ее улучшить. Поэтому единственная демонстрация на Форуме, в которой напрямую сравнивались Intel и AMD, была посвящена именно серверным четырехъядерникам. Проводивший ее Пэт Гелсингер устроил небольшую эффектную сценку с демонстрацией «в реальном времени» двух соревнующихся систем и образцово-показательными замерами, в которых двухъядерный Xeon значительно обошел двухъядерный Opteron не только по скорости, но и по энергопотреблению, после чего был за пару минут заменен на четырехъядерный, который увеличил отрыв в производительности еще больше, почти до двукратного, и все равно показал меньшее энергопотребление. Но несмотря на бодрые реляции о том, что TDP для серверных квадов по сравнению с дуалами увеличен не будет, а грядущие низковольтные версии еще и снизят его до 50 Вт, боюсь, в реальной жизни дела будут обстоять не столь радужно. Все же не случайно запущенный на сцене четырехъядерник работал на гораздо более низкой частоте, чем его двухъядерные оппоненты, а в качестве тестового приложения было выбрано прекрасно распараллеливающееся практически на любых системах перемножение пары огромных матриц, на котором было показано отнюдь не двукратное увеличение производительности, ожидающееся от квадов.  На рынке десктопных процессоров системы на базе четырех чипов Core тоже встречает своя ложка дегтя. Поскольку серьезных оптимизаций под многоядерные системы до сих пор нет, а конкурент, оглушенный чрезвычайно удачным Core 2 Duo, особенно не сопротивляется, то с выводом на этот рынок квадов Intel спешить не будет, постаравшись для начала выжать побольше из двухъядерных CPU. А в качестве своеобразного Killer App, ориентированного на ближайшее будущее, предлагает задействовать многоядерники… под компьютерные игры! 1, 2, 3, 4, 5, 6, 7, 8 |

|||||||||